Принцип работы Robots.txt

Здравствуйте, на связи Артём Санников. И сегодня мы разберемся с файлом Robots.txt, а именно: узнаем, что это такое и познакомимся с принципом работы.

Что такое Robots.txt?

Robots.txt — Файл ограничения доступа к содержимому вашего сайта роботам поисковых систем на http-сервере. Если говорить простым языком, то это файл — который держит в узде роботов поисковых систем и не дает им сделать лишних действий.

Файл Robots.txt должен храниться в корневом каталоге сайта, например:

http://test.ru/robots.txt

Как работает Robots.txt

Robots.txt используется для частичного управления индексирования сайта поисковыми системами. Так же Robots.txt может указать на месторасположение, какого-либо файла, и что нужно проиндексировать поисковому роботу.

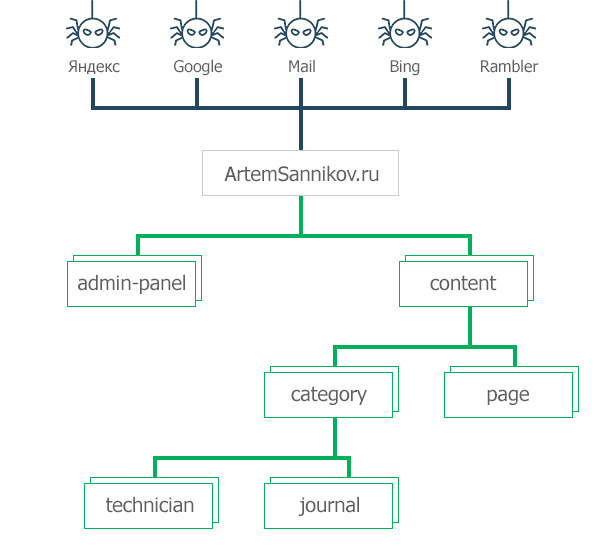

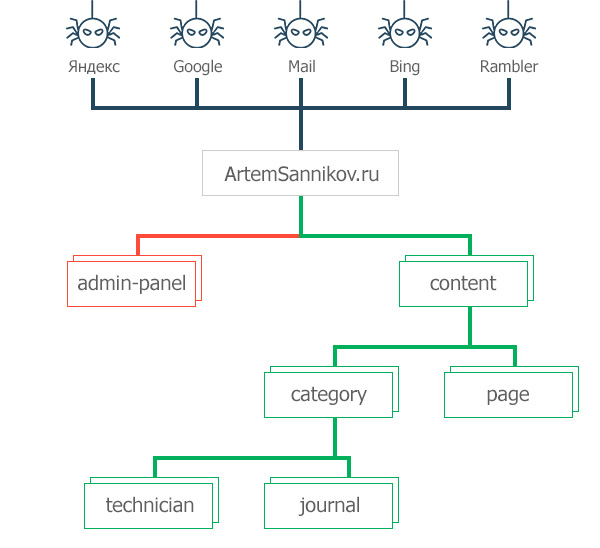

Для того чтобы вы понимали о чем я говорю, рассмотрим небольшой пример: У нас есть сайт, у которого нет файла robots.txt, тогда нас ждет следующая ситуация: Пауки (роботы) поисковых систем не обнаруживают на нашем сайте файл robots.txt и начинают индексировать абсолютно весь сайт без каких-либо запретов с нашей стороны.

Зеленые линии – обозначают, что паукам разрешено индексировать файлы.

Но как только мы добавим на наш сайт файл Robots.txt, у пауков поисковых систем появятся точные границы, дальше которых они не смогут проползти. Следовательно, пауки будут индексировать только те файлы, которые мы им разрешим.

Красные линии – обозначают, что паукам запрещено индексировать файлы.

Для того, чтобы создать ограничения для пауков необходимо знать синтаксис файла Robots.txt. Изучением синтаксиса мы займемся в следующей статье — Синтаксис файла Robots.txt.

Метки: Robots, База знаний.